以下是对一部分多模态文档检索领域论文的模型分析,包括Donut、TextMonkey、DocPedia、mPLUG系列。

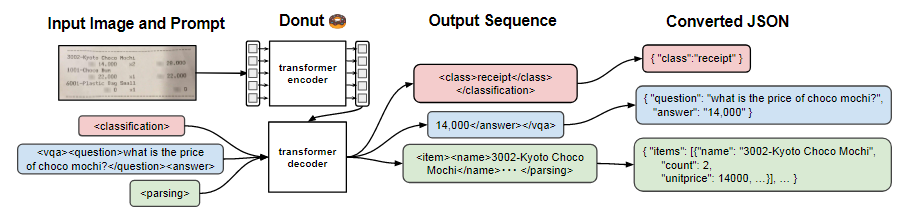

Donut

将图片通过encoder进行编码,得到其hidden state;再将hidden state和prompt一同输入decoder,得到最终输出。

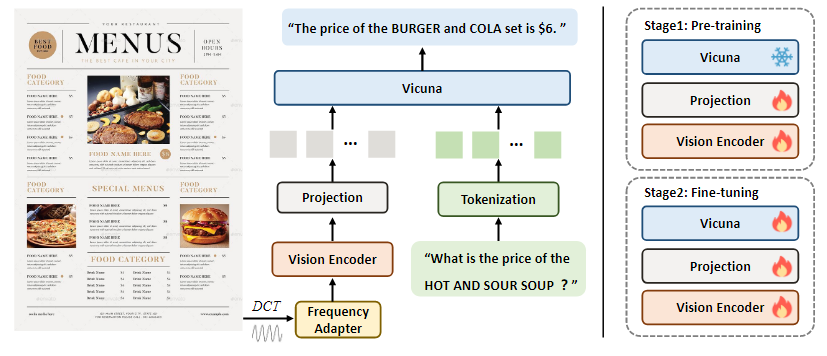

DocPedia

DocPedia的核心在于使用DCT变换,使得图像特征不受分辨率限制。通过这种方式,图像最大可以为2560*2560分辨率。

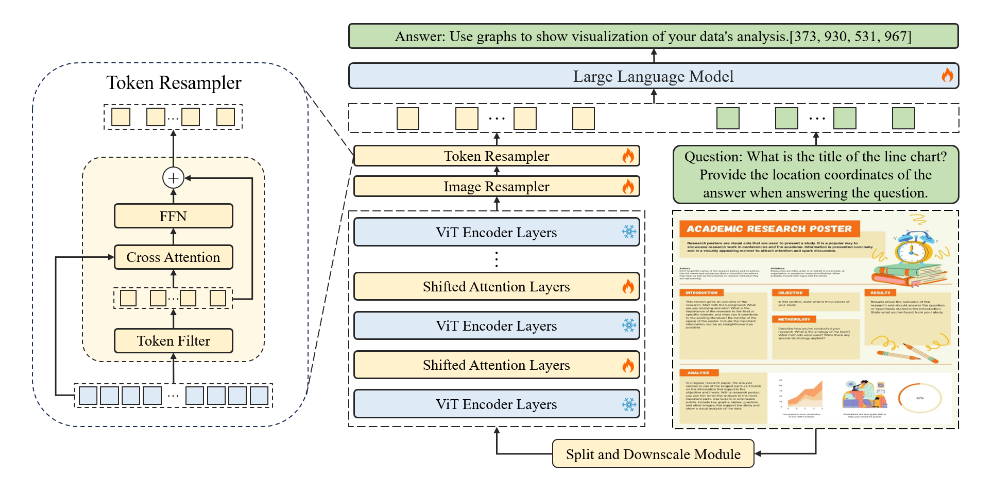

TextMonkey

TextMonkey在Monkey的基础上使用了shift window与token resampler方法,前者可以计算不同patch之间的attention score,后者可以将大量冗余的token进行合并,降低计算复杂度。

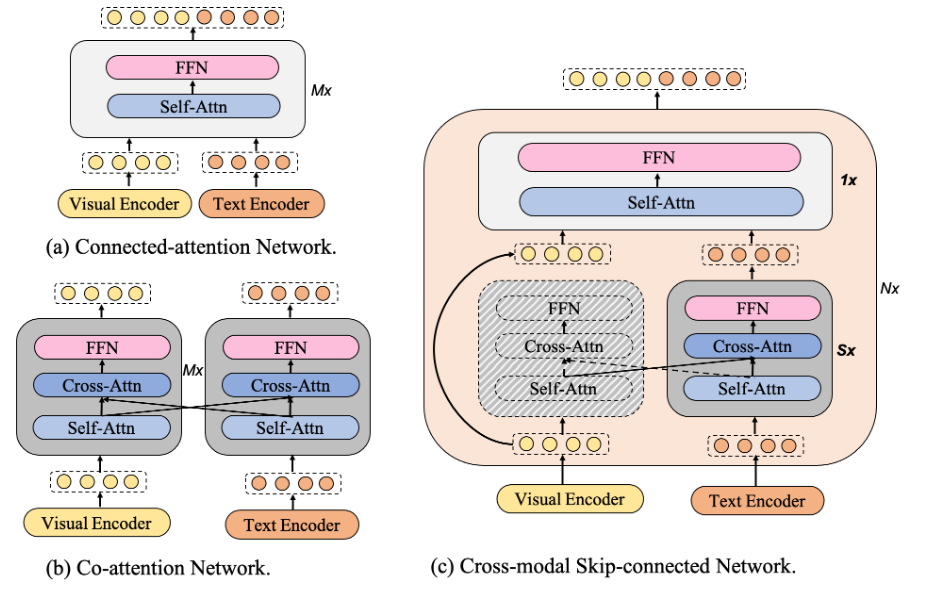

mPLUG系列

mPLUG是系列模型的起源,该模型可以将图像和文本两种信息输入并进行融合。模型提出了skip connection的方法来跳过冗余视频特征,从而搭建了一个图文预训练模型。这个模型可以解决多种多模态任务。

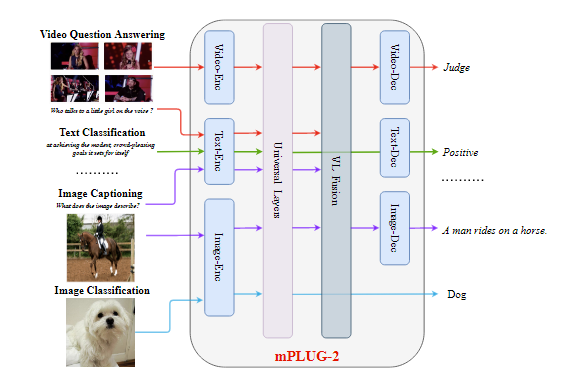

mPLUG-2模型是模块化的模型,不同的任务使用不同的输入输出头,但内部的处理单元是统一的。这样就实现了模块化的大一统模型,在一定程度上解决了模态拉扯的问题。

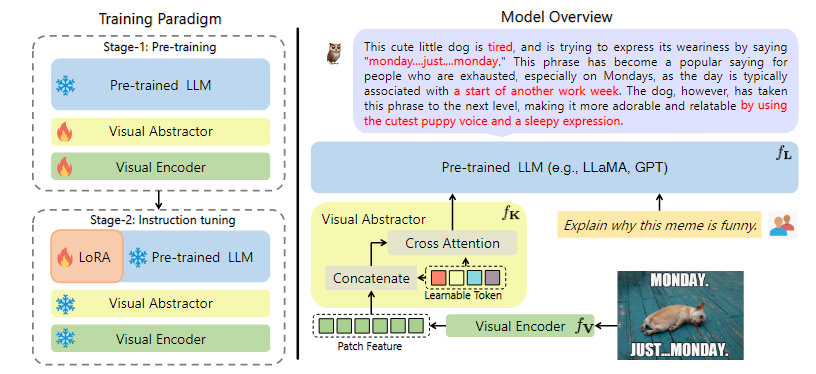

mPLUG-Owl是多模态对话大模型,将预训练的LLM和visual encoder结合,从而使用预训练参数降低训练开销。

- 第一阶段对图文预训练,对齐文本图像空间:将LLM参数frozen,训练visual abstractor和visual encoder。其中visual abstractor和TextMonkey中的token resampler想法类似,将大量patch的冗余信息删除,得到更加详细的token;

- 第二阶段使用LoRA对LLM做instruction tuning,将visual abstractor和visual encoder参数frozen。

mPLUG-Owl2使用了mPLUG-2的模态协同思想,同时提升文本和多模态任务的性能。(部分解决了模态拉车的问题,不会在提升多模态能力时导致LLM本身理解能力降低)

mPLUG-DocOwl针对文档理解做了优化。

- 对于高分辨率的不规则大小图片,使用“形状自适应切图”,将原图裁剪为适配visual encoder的子图;

- 对子图进行编码,位置信息通过LLM语言端进行理解。

文档使用abstractor可能导致空间位置信息丢失,因此将abstractor换为H-Reducer,其在时间上做卷积,降低token数同时保留空间信息。